— 苹果开源FastVLM视觉语言模型 为智能穿戴设备铺路 —

更新时间:2025-05-13 18:33:01 编辑:丁丁小编

本文转载于:https://www.sohu.com/a/894773657_223764 如有侵犯,请联系dddazheyh@163.com删除

热门文章榜

-

- 华为智选WIKO X70官宣,主打“昆仑品质”与北斗卫星通信

- 华为智选WIKO X70官宣,主打“昆仑品质”与北斗卫星通信

- 立即抢购

-

- 大疆发布三款农业无人机,从旗舰到入门,覆盖多元作业场景

- 大疆发布三款农业无人机,从旗舰到入门,覆盖多元作业场景

- 立即抢购

-

- vivo联袂顺丰革新"顺回收",以旧换新+保值焕新重塑手机消费体验

- vivo联袂顺丰革新"顺回收",以旧换新+保值焕新重塑手机消费体验

- 立即抢购

-

- 飞猫AI WiFi 新品上市:重构办公学习流,网络与 AI 大脑合二为一

- 飞猫AI WiFi 新品上市:重构办公学习流,网络与 AI 大脑合二为一

- 立即抢购

-

- OPPO Find X9系列外观正式亮相!绒砂工艺+全新四色

- OPPO Find X9系列外观正式亮相!绒砂工艺+全新四色

- 立即抢购

-

- OPPO Find X9 Pro性能体验:天玑9500+潮汐引擎实现极致稳定性能

- OPPO Find X9 Pro性能体验:天玑9500+潮汐引擎实现极致稳定性能

- 立即抢购

热门优惠券

更多-

立即领取

立即领取ShopbopScore up to 50% off designer must-haves, plus get an extra 10% off all sale styles. Use code

ShopbopScore up to 50% off designer must-haves, plus get an extra 10% off all sale styles. Use code -

立即领取

立即领取ShopbopScore up To 25% Off Top-Selling Styles During the Style Event with Code STYLE

ShopbopScore up To 25% Off Top-Selling Styles During the Style Event with Code STYLE -

立即领取

立即领取CasetifyUse Code: SPOOKY25 and Buy 1 Get 15% Off, Buy 2+ Get 20% Off

CasetifyUse Code: SPOOKY25 and Buy 1 Get 15% Off, Buy 2+ Get 20% Off -

立即领取

立即领取Shopbop20% OFF BEAUTY: Including skincare, makeup & more with code BEAUTY20

Shopbop20% OFF BEAUTY: Including skincare, makeup & more with code BEAUTY20 -

立即领取

立即领取CasetifyUse Code BTS25 to Save up to 25% OFF

CasetifyUse Code BTS25 to Save up to 25% OFF

最新分享

更多-

立即阅读

立即阅读买平板就买鸿蒙平板:你的年度全能搭子来了!

2025-12-17 21:18:01 -

立即阅读

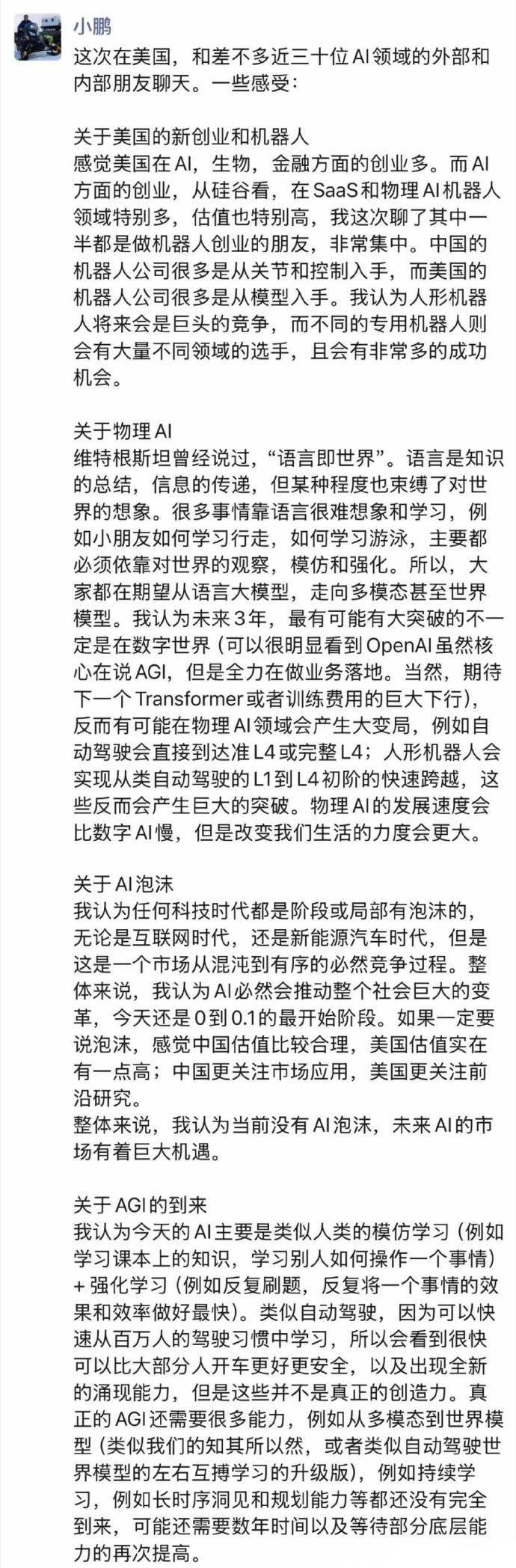

立即阅读何小鹏谈AI发展前景:当前无泡沫未来机遇大 人形机器人将成巨头竞技场

2025-12-17 18:48:03 -

立即阅读

立即阅读满配标准版+骁龙8 Gen5 小屏,vivo S50系列火热预售!

2025-12-17 18:27:05 -

立即阅读

立即阅读iPhone 18 Pro或取消灵动岛:传将采用单孔屏与屏下Face ID方案

2025-12-17 18:21:01 -

立即阅读

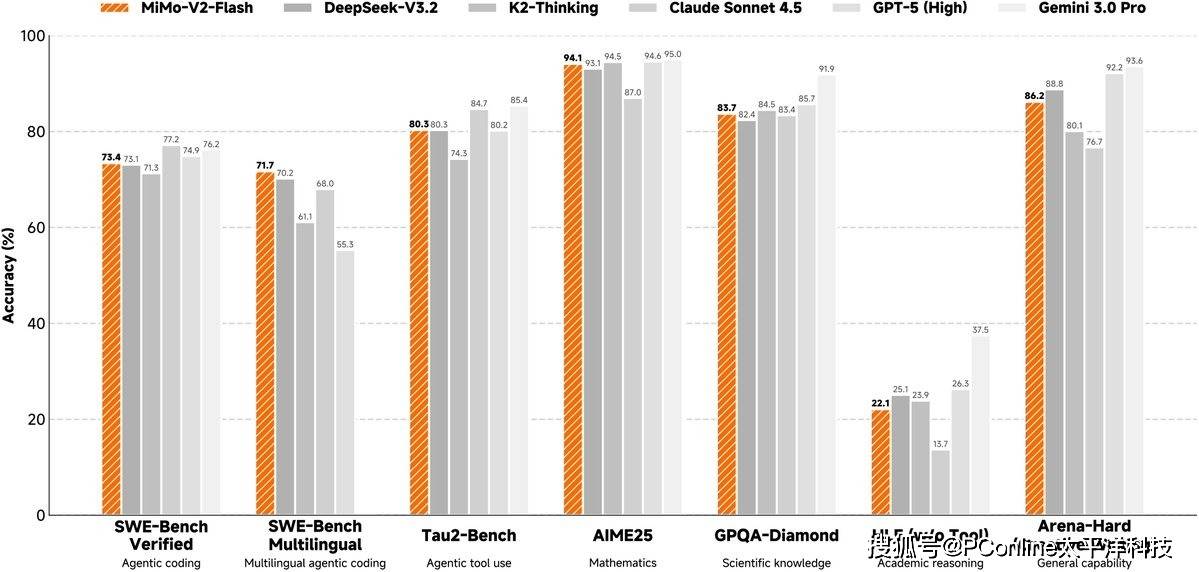

立即阅读罗福莉掌舵小米AI:发布MiMO大模型 剑指通用智能

2025-12-17 18:18:10 -

立即阅读

立即阅读销售遇冷,传苹果iPhone Air 2将升级双摄并下调售价

2025-12-17 17:36:02 -

立即阅读

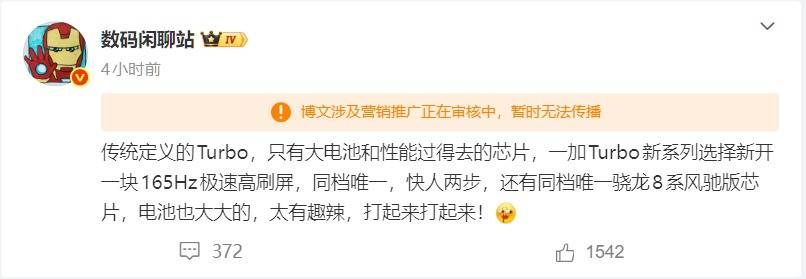

立即阅读一加Turbo新机爆料:同档唯一原生165Hz大R角屏和骁龙8系风驰版芯片

2025-12-17 17:33:01 -

立即阅读

立即阅读满帧性能,日用全能!一加 Ace 6T闭眼冲!

2025-12-17 17:27:01 -

立即阅读

立即阅读骁龙8 Gen 5+8300mAh大电池!一加 Ace 6T打造全新性价比之选

2025-12-17 17:20:57 -

立即阅读

立即阅读荣耀WIN系列开启预订,全系 8 Elite系列旗舰芯+10000mAh电池

2025-12-17 17:17:56